INTRODUCTION

Après l’avènement des chatbots, puis celui du metaverse, nous voici immergé·es, de gré ou de force, dans l’ère de l’intelligence artificielle. Nombre de keynotes speakers au sourire étincelant nous vantent quotidiennement les formidables effets de ces nouveaux outils : Dall-E, ChatGPT, Midjourney, Firefly, Staple Diffusion, Leonardo, Perplexity, Bard, … Alors, comme tiré·es du marasme de nos routines, nous nous plongeons dans les méandres du prompt*, traçant sans le vouloir les sillons de nouveaux métiers.

Car il est bien question ici d’adaptation, et probablement de survie. Certain·es diront qu’il s’agit là d’une histoire, assez banale, de relation entre “désir, illusion et action” (Kate Crawford), tels que le fondent bien souvent les miracles de l’innovation.

Dans nos métiers de communication, le sujet de l’IA est fréquemment réduit à la question de savoir si nous allons parvenir à rester à la page, à maîtriser ces nouveaux outils, à en tirer bénéfice, ou à faire en sorte que nos métiers ne s’effondrent pas. Pourtant, il s’agit avant tout de savoir vraiment de quoi nous parlons pour mieux connaître ce que nous avons à y perdre ou à y gagner véritablement.

Je vous propose ainsi, toujours dans une démarche à la fois critique & contributive, nécessairement partielle, de nous plonger dans ce passionnant sujet.

—

* Il y aurait beaucoup à dire sur le prompt, ce champ qui permet de lancer des requêtes et dont on ignore ce qu’elles explorent, par où elles cheminent et ce qu’elles vont véritablement puiser. Les comportements qu’il induit, comme prendre l’habitude de raffiner ses requêtes en les ajustant par petites touches pour extraire des résultats dont la créativité se mesure à l’aune de statistiques tirées d’immenses bases de données. Réussir à constituer une requête de qualité est devenu un enjeu essentiel dans l’univers des “modèles d’IA génératives” qui nous pousse à trouver les meilleurs cheat codes ↗ (“codes de triche” faisant de nous une nouvelle forme de “growth hacker”) grâce auxquels nous parviendrions à transcender la machine… et peut-être un peu nous-même ?

🧭 Brian Solis (qui se qualifie lui-même de keynote speaker) propose, dans une orientation marketing, un panorama d'outils qui intègrent un modèle d'IA ↗

DÉFINITIONS

1/ Un territoire en mouvement

“L’intelligence artificielle” n’est pas un champ de recherche qui aurait connu une évolution linéaire au fil du temps, depuis sa naissance un peu avant les années 1950. Ce domaine regroupe de nombreuses disciplines (parmi les sciences, théories & techniques) dont l’informatique, la neurobiologie computationnelle, la linguistique, la logique mathématique, les statistiques & probabilités…

— Définitions

Du fait de cette pluridisciplinarité sa définition reste polysémique et élastique. Ce qui est un sujet en soi : si en tant qu’acteur·ices de la communication publique, nous abandonnons cette définition à de grandes marques ou de grandes plateformes, ce sera sans nul doute “le marketing et la publicité [qui] en prédétermineront l’horizon”.

Voici donc deux définitions complémentaires qui me semblent particulièrement inspirantes pour nos métiers de communication, formulées par deux scientifiques internationalement reconnues : Dr Aurélie JEAN* et Dr Kate CRAWFORD*.

Selon Aurélie Jean, “l’IA représente l’ensemble des simulations sur ordinateur qui reproduisent virtuellement et artificiellement une certaine intelligence – car elle ne reproduit pas l’intelligence humaine dans sa globalité et sa complexité –.” Il s’agit selon la chercheuse d’une “intelligence analytique exclusivement vouée au raisonnement analytique, parfois mathématique, utilisée pour résoudre un problème ou répondre à une question.”

Kate Crawford envisage l’IA comme une “industrie extractive” : “l'intelligence artificielle se définit comme une formation industrielle massive qui inclut politique, main d’œuvre, culture et capital.” Le terme intelligence artificielle répond, selon elle, du vocabulaire du “marketing, la recherche utilisant plutôt celui d’apprentissage automatique, qui recouvre une large gamme d’approches techniques – qui sont en fait également sociales et infrastructurelles, mais rarement désignées comme telles –. (…) L’élasticité de l’expression intelligence artificielle”, poursuit la chercheuse, “nous permet d'envisager tous ces éléments et comment ils sont profondément imbriqués : de la politique du renseignement à la collecte massive de données, de la concentration industrielle du secteur tech à la puissance militaire géopolitique, de la dévastation environnementale aux formes toujours actuelles de discrimination.”

—

* Dr Aurélie JEAN est chercheuse & entrepreneuse française, numéricienne – “computational scientist” –, a étudié mécanique & génie civil à l’ENS Paris-Saclay, docteure en ingénierie & sciences des matériaux à Mines Paris-Tech | Dr Kate CRAWFORD est une chercheuse australienne, Professeure à l’école de journalisme & de communication de l’Université de Californie, responsable de recherche au New York City Lab de Microsoft Research, titulaire de la chaire “IA & justice” à l’ENS Paris, co-fondatrice de l’AI Now Institute

— Stupidité artificielle

Quand l’humoriste Woody Allen évoque dans une boutade “l’intelligence artificielle [comme] l’inverse de la stupidité humaine”, il se limite à un simple jeu de mots. Les deux chercheuses vont naturellement bien plus loin lorsqu’elles se saisissent toutes deux de la notion de “stupidité artificielle” pour tenter de proposer un angle d’approche qui soit résolument axé sur les effets sociaux, en contrepoint de celui qui nous est habituellement présenté.

L’artiste Hito STEYERL* utilise ce terme pour qualifier les “systèmes d’IA faibles qui provoquent”, selon elle, “les retombées sociales les plus graves”. Elle nomme ces systèmes “stupidité artificielle” et pense “qu’ils ont déjà un impact majeur sur nos vies. La principale conséquence sera bien sûr l’automatisation (…) déjà à l’origine d’inégalités importantes et d’une fragmentation sociale - mouvements nativistes, semi-fascistes, voire fascistes.”

« Plus ces programmes deviendront “intelligents”, plus la fragmentation sociale augmentera, ainsi que la polarisation. » Hito Steyerl

Il semble que ce soit Yoshua BENGIO* qui utilise la métaphore en premier, lorsqu’il déclare en 2016 qu’il avait “l’habitude de penser que nous ne devrions pas appeler l’intelligence artificielle de terrain, mais la stupidité artificielle.” D’ajouter que “vraiment, nos machines sont stupides, et nous essayons juste de les rendre moins stupides”. Il ajoute, également dans une perspective sociale : “je suis plus préoccupé par l’utilisation abusive de l’IA. Des choses comme les mauvaises utilisations militaires, la manipulation des gens par la publicité vraiment intelligente ; […] aussi, l’impact social”.

—

* Hito STEYERL est réalisatrice & autrice allemande de documentaires vidéo, spécialisée dans les médias, la technologie et la circulation mondialisée des images, docteure en philosophie de l’académie des Beaux-Arts de Vienne | Yoshua BENGIO est professeur titulaire à l’Université de Montréal, fondateur et directeur scientifique de l’institut québécois d’IA, lauréat du Prix Turing en 2018

🧭 Entretien croisé entre Hito Steyerl et Kate Crawford Data Stream ↗ , The New Inquiry, janvier 2017 | Yoshua Bengio, Les machines nous élimineront-elles ? ↗ , MIT News, janvier 2016

— Glossaire de survie

Pour nous aider à appréhender les mécaniques, commençons par nous approprier le vocabulaire courant.

• Algorithme

“instruction qui commande le fonctionnement des programmes informatiques” (Dominique Cardon). L’algorithmique est la science visant à créer des algorithmes, ces “chemins de résolution pour un problème donné, […] de plus en plus rapides et utilisant le moins possible de mémoire de stockage” (Aurélie Jean).

• Loi de Moore

L’informatique est connue pour sa croissance et son amélioration exponentielles, caractérisées par la loi empirique énoncée par Gordon Moore (co-fondateur d’Intel) en 1965 selon laquelle “l’observation empirique que la complexité des circuits intégrés, par rapport au coût minimum des composants, double tous les 24 mois” (source : CNIL). Autrement dit “le nombre de transistors sur une puce électronique de taille constante double tous les ans dans les années 1970, tous les deux ans dans les années 1980.”

• Machine Learning

“L’apprentissage automatique (machine learning en anglais) est un champ d’étude de l’intelligence artificielle qui vise à donner aux machines la capacité d’« apprendre » à partir de données, via des modèles mathématiques. Plus précisément, il s’agit du procédé par lequel les informations pertinentes sont tirées d’un ensemble de données d’entraînement. Le but de cette phase est l’obtention des paramètres d’un modèle qui atteindront les meilleures performances, notamment lors de la réalisation de la tâche attribuée au modèle. Une fois l’apprentissage réalisé, le modèle pourra ensuite être déployé en production.” (source: CNIL)

• Deep Learning

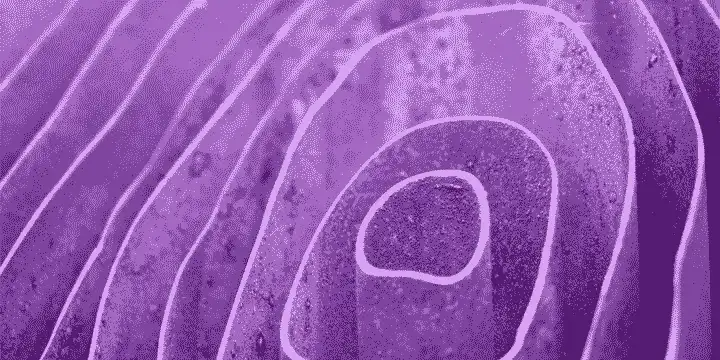

“L’apprentissage profond (deep learning en anglais) est un procédé d’apprentissage automatique utilisant des réseaux de neurones artificiels possédants plusieurs couches de neurones cachées. Ces algorithmes possédant de très nombreux paramètres, ils demandent un nombre très important de données afin d’être entraînés.” (source: CNIL)

• Réseau de neurones artificiels

Un réseau de neurones artificiels (Artificial Neural Network en anglais) est un “ensemble organisé de neurones artificiels (qui fonctionnent d’une manière inspirée de celle d’un neurone biologique : un nœud d’un réseau de plusieurs neurones reçoit généralement plusieurs valeurs d’entrée et génère une valeur de sortie, en appliquant une fonction d’activation à une somme pondérée des valeurs d’entrée) interconnectés permettant la résolution de problèmes complexes tels que la “vision par ordinateur” (qui permet à une machine d’analyser et traiter une ou plusieurs images ou vidéos prises par un système d’acquisition) ou le traitement du langage naturel (dans le but d’interpréter et de synthétiser du texte). Il s’agit d’un type particulier d’algorithmes d’apprentissage automatique (comme les machines à vecteur de support, arbres de décision, K plus proches voisins, etc.) caractérisés par un grand nombre de couches de neurones, dont les coefficients de pondération sont ajustés au cours d’une phase d’entraînement (apprentissage profond). Il existe de nombreux type de réseaux de neurones artificiels.” (source: CNIL)

• Vision par ordinateur

La “vision par ordinateur” est une “branche de l’IA dont le principal but est de permettre à une machine d’analyser et traiter une ou plusieurs images ou vidéos prises par un système d’acquisition” (source : CNIL)

• Modèles de langage

“Modèle statistique de la distribution d’unité linguistiques (par exemple : lettres, phonèmes, mots) dans une langue naturelle. Un modèle de langage peut par exemple prédire le mot suivant dans une séquence de mots. On parle de modèles de langage de grande taille ou « Large Language Models » (LLM) en anglais pour les modèles possédant un grand nombre de paramètres (généralement de l’ordre du milliard de poids ou plus) comme GPT-3, BLOOM, Megatron NLG, Llama ou encore PaLM.” (source: CNIL)

—

2/ Jalons historiques

L’évolution historique des modèles d’IA se mesure notamment sur la base des évolutions des composants électroniques, ainsi que du nombre de calculs qu’une ressource donnée peut effectuer en une seconde (mesurés en FLOP/s). Le consensus scientifique s’entend sur 3 principaux jalons :

- 1950-2010 = naissance & développement de l’IA, basée sur la puissance des micro-processeurs selon la loi de Moore*, depuis l’évocation par Alan Turing en 1950 de “l’intelligence des machines” (test de Turing ou jeu de l’imitation), dont l’algorithmique et le traitement automatique des langues

- 2010-2022 = ère de “l’apprentissage profond” (Deep Learning*) = “procédé d’apprentissage automatique utilisant des réseaux de neurones possédants plusieurs couches de neurones cachées. Ces algorithmes possédant de très nombreux paramètres, ils demandent un nombre très important de données afin d’être entraînés.” (source: CNIL)

- 2015-2024 = ère du Large Scale (Large Language Model Cf. Modèles de langage*) => utilise “100 fois plus de calculs que les modèles contemporains d’IA”, et continue de croître pour un développement exponentiel des capacités et performances sur les marchés (les puces par exemple seront 30x plus onéreuses)

Depuis l’origine de l’informatique et des sciences computationnelles, nous sommes collectivement engagé·es dans une dynamique expansionniste du progrès, sans que soit véritablement prises en compte les limites planétaires ↗ . Ainsi, plus les modèles se développent, plus les besoins en ressources sont exponentiels. Prenons l’exemple des transistors intégrés aux micro-processeurs de nos ordinateurs : dans les années 70, 1 ordinateur sous processeur Intel intégrait ~4000 transistors, dans les années 2010 il avoisinait le milliard. (source : Wikipedia ↗ )

Cette échelle se reporte inéluctablement sur l’extraction des minerais nécessaires à la fabrication de ces micro-processeurs. Pour vous donner un ordre de grandeur relativement à la dynamique de fabrication des batteries électriques des machines : 1 smartphone contient ~8,5 grammes de lithium, tandis que le bloc-batterie d’une Tesla Model 5 en contient 62 kg (source : Kate Crawford), pour quelques 200 micro-ordinateurs embarqués (source : Gauthier Roussilhe). Autre exemple, OpenAI (à l’origine de ChatGPT) estime que la puissance de calcul pour former 1 seul modèle d’IA est multipliée par 10 chaque année depuis 2012 (source : Kate Crawford). Enfin, et nous le verrons plus loin, il n’est guère étonnant dans ce contexte d’observer le poids de plus en plus important qu’occupe la société NVidia – fondée en 1993 en Californie, “n° 1 mondial de la conception, du développement et de la commercialisation de processeurs graphiques programmables” – parmi les entreprises Tech les plus puissantes au monde.

La (dynamique de) numérisation croissante de nos sociétés, étayée par une automatisation de plus en plus prégnante, permet assez aisément de mesurer les perspectives réelles qu’offre le développement des modèles d’apprentissage automatiques (“IA”).

3/ Angles morts & impensés de l’IA : une multitude de pouvoirs imbriqués

L’approche critique dans l’étude des modèles d’apprentissages automatiques (IA) atteint toutefois rapidement ses limites car on n’y trouve “pas de boîte noire à ouvrir, pas de secret à révéler, mais une multitude de systèmes de pouvoirs imbriqués” (Kate Crawford).

— Matérialité de l’IA

La matérialité de l’IA dessine des paysages de computation planétaire souvent éloignés des grands centres de pouvoir, néanmoins bien réels : lacs de lithium en République Démocratique du Congo, à Silver Peak (Nevada, USA) ou Salar d’Uyuni (Bolivie) ; puits de mine désaffectés de la ville “fantôme” & contaminée au cyanure de Blair (désert du Nevada, USA), terre orange & stérile des mines d’étain de Bangka & Belitung (îles d’Indonésie) ou encore la boue toxique du lac artificiel de Baotou (Mongolie-Intérieure) ; immenses corridors des centres de données énergivores de Bluffdale (Utah, USA) ; entrepôts des centres de livraison d’Amazon, éclairés au néon et où les antalgiques sont distribués librement pour que les corps résistent aux cadences automatisées par l’IA ; …

« Le cloud est la colonne vertébrale de l’industrie de l’IA, et il est fait de pierres, de saumure de lithium et de pétrole brut. » (Kate Crawford)

— Empreinte écologique

Incarnée par la matérialité de l’IA, son empreinte écologique est systématiquement invisibilisée. Il est certes extrêmement complexe de mesurer globalement l’empreinte d’un modèle d’apprentissage automatique, sur l’ensemble de son cycle de vie et de sa chaîne systémique. Néanmoins son invisibilisation fait partie intégrante des stratégies d’expansions des grands groupes qui s’y adossent. L’artiste Vladan Joler a tenté de formaliser les soubassements de l’extractivisme inhérent aux modèles d’IA au travers de son œuvre “Anatomie d’un système d’IA” en 2018. Il est également difficile de mesurer pragmatiquement l'hyper-consommation d’énergie électrique nécessaire au fonctionnement de ces modèles. Sans oublier l’évolution similaire concernant les données : “le volume de données produit dans le monde devrait passer de 33 zettaoctets* en 2018 à 175 en 2025.” (source: Parlement Européen)

« Le cloud est une technologie extractive, grande consommatrice de ressources, qui convertit l’eau et l’électricité en puissance computationnelle, créant au passage d’important dégâts environnementaux qu’elle s’efforce ensuite de masquer. » (Tung-Tui Hu, A Prehistory of the Cloud)

— Risques d’usage face à la pénurie des ressources

Il n’est pas inutile de se rappeler régulièrement que le fait de lancer de nouveaux services (notamment de communication), ou de développer de nouvelles organisations de production basées sur des services d’IA, présente un risque non négligeable pour l’avenir compte-tenu de la raréfaction des ressources primaires. Il est certainement question ici de souveraineté ou de continuité des missions du service public.

— Enjeux sociaux & démocratiques

Ce sujet porte bien au-delà des questions habituellement abordées et bien souvent limitées à la restructuration du marché de l’emploi ou à certains impacts économiques. Il s’agit de questionner notamment les enjeux de production, d’analyse, de diffusion & de circulation de l’information, de son accès et de sa contribution à “une vie démocratique désaliénée” (Nathanael Valenhorf). Depuis les travaux de Antonio Casilli, nous savons que les enjeux portent plus largement sur les modèles de travail générés par les systèmes d’automatisation, directement ou indirectement (“l’automate et le tâcheron”, “les travailleur·euses du clic”…), dans les pays qui exploitent ces services comme dans ceux qui fabriquent les machines & composants, ou ceux qui produisent la matière première nécessaire. Des biais discriminatoires liés aux algorithmes d’accès aux droits, jusqu’aux conflits qui déchirent la République Démocratique du Congo depuis plus de 30 ans, ce sont autant de témoignages marquant des effets démocratiques & sociaux de tels modèles.

— Enjeux culturels

Les questions des droits d’auteurs et du rôle des licences libres est encore rarement posé. Les enjeux de liberté & de singularité de la création sont également à interroger, par-delà les rares modèles – souvent creux – qui nous sont exposés (NFT, Metavers, dispositifs immersifs…). La question de la singularité des cultures autochtones est également essentielle, de même que celle des communs.

« J’affirme que l’IA n’est ni artificielle ni intelligente. […] Et à cause du capital nécessaire pour produire l’IA à grande échelle et des manières de voir qu’il optimise, les systèmes d’IA sont finalement conçus pour servir les intérêts dominants. En ce sens, l’intelligence artificielle est le reflet du pouvoir. » (Kate Crawford)

—

* 1 zettaoctet représente 1000 milliards (10 puissance 12, soit 1 billion) de gigaoctets

🧭 Vladan Joler & Kate Crawford, Anatomie d'un système d'IA ↗ , œuvre exposée au Museum of Modern Art (MoMA), New York, 2018 | Recommandation sur l’éthique de l’intelligence artificielle ↗ , UNESCO, novembre 2021 | Antonio Casilli, L'automate et le tâcheron ↗ : dépasser la rhétorique de la “destinée manifeste” de l’IA, Institut d’Etudes Avancées de Nantes, février 2020 | David Maenda Kithoko, Pour une écologie décoloniale du numérique ↗ , intervention lors de la Journée écoconception numérique, Designers éthiques, février 2024 | Artistes face à l'IA : que reste-t-il du droit d'auteur ? ↗ , “Le meilleur des mondes”, France Culture, octobre 2023

INJONCTIONS

1/ Ne pas envisager l’IA ?

— La fin de l’humanité

Peut-on raisonnablement échapper à l’avertissement crépusculaire énoncé par Stephen Hawking en 2014 ? Selon lui, “les formes primitives d’intelligence artificielle que nous avons déjà se sont montrées très utiles. Mais je pense que le développement d’une intelligence artificielle complète pourrait mettre fin à l’humanité. (…) Une fois que les hommes auraient développé l’intelligence artificielle, celle-ci décollerait seule, et se redéfinirait de plus en plus vite. Les humains, limités par une lente évolution biologique, ne pourraient pas rivaliser et seraient dépassés”.

Voilà qui est dit.

—

🧭 Entretien accordé par Stephen Hawking ↗ à la BBC en décembre 2014

— Omniprésence

Difficile de ne pas envisager les modèles d’apprentissage automatique dès lors qu’ils sont déjà omniprésents dans le vaste champ des services numériques & du web. Dès lors que nous les utilisons déjà sans vraiment le savoir. Depuis les années 50 ces modèles se développent de plus en plus, inondent les marchés et “musclent” nos logiciels.

De nos jours, on en retrouve un peu partout, notamment pour :

- piloter des voitures autonomes (Tesla, Cruise / General Motors, Zoox / Amazon, Waymo / Alphabet…) ou guider des chiens mécaniques robots de combat (Boston Dynamics…)

- répondre aux questions et fournir des services à l’aide d’assistants vocaux / agents conversationnels & autres chatbots (Siri / Apple, Alexa / Amazon, Google Home, Cortana / Microsoft, ChatGPT / OpenAI…)

- centraliser & traiter les données de santé (Health Data Hub)

- surveiller les citoyen·nes par la reconnaissance faciale et la surveillance biométrique

- gérer les accès aux droits à l’aide d’algorithmes de contrôle social (CAF, ParcoursSup, ·), jusqu’aux algorithmes de crédit social en Chine

- créer de nouveaux contenus à l’aide des outils d’IA génératives (traitement textuel / audio / vidéo)

Aujourd’hui les publicités en sont envahies, quel que soit le domaine, incarnant un “argument de vente” incontournable pour les marques qui souhaitent renforcer une certaine promesse de puissance.

—

🧭 Paris-2024 : les JO, cheval de Troie de la vidéosurveillance algorithmique ? ↗ , France 24, mars 2023

— Influence des Big Tech

Comment ne pas considérer l’influence économique majeure des Big Tech (Amazon, Apple, Alphabet, Meta, Microsoft, InVidia, Tencent, Baidu, Samsung…) sur nos usages & appropriations de ces modèles d’apprentissage automatique (IA) ? Voici quelques indicateurs financiers pour nous en convaincre :

- La Chine est le pays qui investit le plus dans les brevets en lien avec l’IA : Tencent & Baidu ont capitalisé 20.000 brevets en 2021 (~6000 pour Microsoft, 4000 pour Alphabet) (source : CBInsights)

- L’investissement mondial total dans les modèles d’apprentissage automatique s’élève à 190 milliards $US en 2022 : en nette hausse depuis les années 2010 (+1800% depuis 2013) mais en baisse de 30% par rapport à 2021 (source : Stanford University / Statista)

- Depuis que l’industrie du cloud montre des signes de baisse (perte de parts de marché depuis 2021 de près de 30% pour Amazon Web Services, 20% pour Google Cloud ou Azure Cloud Services, probablement lié à un seuil du marché), les systèmes d'IA générative sont devenus le nouveau champ de bataille des Big Tech. La compétition est rude et elles multiplient les investissements dans les starts-up ainsi que les alliances technologiques & stratégiques pour tenter de gagner la course aux profits.

- Les chantiers portés par les Big Tech sont nombreux dans le domaine : apprentissage automatique, apprentissage profond, vision par ordinateur, robotique, informatique quantique…

- Quelques projets internes aux Big Tech, hors investissements ou acquisitions :

- Amazon = A9, Alexa, MXNet, Polly, Rekognition, Go

- Apple = Siri, Core ML, Neural engine, Project Titan

- Meta = M, Big Basic, Caffe2, DeepMask / SharpMask

- Alphabet : Google Home, DeepMind, Alpha Go, Google Brain, TensorFlow, Quantum AI, Waymo; Nest

- Microsoft = Cortana, Azure ML, Cognitive Toolkit, Designer, Project Brainwave, Pix, 2nd Generation Holographic Processing Unit

- NVidia = Picasso generative models

— L’angoisse de survie professionnelle

A l’instar de ce que l’on a pu dire un temps des smartphones, la “peur d’en manquer” (Fear Of Missing Out ou FOMO) frappe nos consciences professionnelles lorsqu’il est question d'“IA”. Impossible, pour rester à la page, de manquer la nouvelle ère qui s’annonce : expertise, crédibilité professionnelle ou reconnaissance de la maîtrise technique sont en jeu. L’angoisse de subir un retard technologique, qui nous ferait beaucoup trop perdre, qui mettrait potentiellement notre survie professionnelle en péril. Dans la réalité, les patrons des Big Tech craignent certainement bien davantage l’avènement de nouvelles formes d’innovations en tant qu’elles pourraient potentiellement ébranler leur équilibre financier s’ils ne parvenaient pas à tirer bénéfice des changements de caps économiques et des nouvelles tendances technologiques. Le risque pèse d’abord sur ces entreprises : qu’avons-nous donc à perdre, dans le quotidien de nos métiers, de prendre le temps de comprendre & de partager nos points de vues, de construire collectivement les perspectives nouvelles de nos métiers ?

2/ Accélérer & s’emparer de l’IA ?

« Le terme intelligence artificielle a pris de nombreuses significations différentes au cours de son histoire et peut être mieux compris comme un terme de marketing plutôt que comme un objet fixe. » (IA Now Institute)

Dans les métiers de la communication – comme c’est probablement le cas dans de nombreux autres domaines – nous avons appris à repérer rapidement les phénomènes émergents sur le marché des médias numériques & des technologies de l’information, à suivre les prescriptions des “expert·es” et à les mettre en application avec forces nouveaux outils et fonctionnalités.

Nous avons ainsi bien souvent tendance à envisager les modèles d’innovation exclusivement sous l’angle du marché. Cette approche est très limitée, particulièrement car elle rend invisible une grande partie des enjeux. Elle se révèle par ailleurs caduque car elle ne permet pas, au-delà de suivre la course effrénée du progrès, de s’emparer de la problématique pour la mettre au service des transitions sociales & climatiques.

—

🧭 Rapport 2023 Landscape ↗ , AI Now Institute, avril 2023

RECOMMANDATIONS

1/ Vers une juste appréhension de l’IA ?

Je tente ici de regrouper quelques recommandations, indépendamment de nos métiers, pour un juste usage des modèles d’apprentissage automatique.

Aurélie Jean et Kate Crawford sont unanimes pour proposer les pistes fondamentales suivantes :

- Comprendre comment les algorithmes fonctionnent

- S’interroger sur ce que sont les modèles d’apprentissage automatique (IA)

- Se demander quelles formes politiques ils propagent, quels intérêts ils servent et qui risque les plus grands préjudices

- Décider d’utiliser ou non ces outils, de quelle manière, sous quelle conditions, à quelle fréquence et potentiellement “rejeter la suggestion algorithmique”

La question qui demeure, au final, porte sur notre capacité à structurer un choix collectif. Yoshua Bengio rappelle ainsi que “la société doit se réunir et trouver une réponse collective” face à ces enjeux. Le juste usage se construit par le travail coopératif et s’appuie sur notre capacité à nous co-adapter. Pour progresser vers plus de justice il s’agit de “suivre la logique du coût environnemental et humain de l’IA pour le replacer dans le contexte des pratiques d’extraction et de classification qui s’entrelacent dans notre quotidien.” (Kate Crawford)

Enfin il s’agit pour nous toutes & tous, professionnel·les de la communication numérique, de définir collectivement les valeurs & conditions d’usage de l’IA qui permettent de mettre en œuvre nos missions. S’inspirer par exemple des axes pour “une intelligence artificielle digne de confiance” proposés par la fondation Mozilla :

- vie privée

- équité

- confiance

- sécurité

- transparence

—

🧭 Intelligence artificielle digne de confiance ↗ , Fondation Mozilla

2/ Vers des pratiques d’IA en communication numérique ?

Afin de tenter de concevoir les usages des modèles d’apprentissage automatique en communication, il semble intéressant de décentrer notre point de vue pour envisager les médias numériques comme des “médias computationnels qui participent désormais aux processus géologiques et climatologiques” (Jussi Parikka, Geology of Media). Cette approche nous permet d’envisager les modèles d’IA à leurs vraies places, au-delà de la question – trop sommaire – de la puissance magique des outils et fonctionnalités, pour estimer collectivement là où leurs usages sont nécessaires.

— Comprendre & situer les usages potentiels

Les grandes pistes d’usages potentiels en communication, quelle que soit la fonctionnalité d’apprentissage automatique, sont bien connues. Rien de bien révolutionnaire ici, le schéma se répète à l’émergence de nouvelles innovations. Dans notre sujet, c’est l’automatisation qui représente la colonne vertébrale des usages :

- Industrialisation de la production : texte, audio, vidéo, images / photos, code…

- Traitement & analyse : analyser des documents, rechercher et traiter de grandes quantité d’informations, analyser la performance au travers de multiples critères, data marketing, reconnaissance & comparaison (photo, texte…), produire des infographies de synthèse à partir de données complexes…

- Conversationnel : modération, agents conversationnels (chatbots…)

Le bénéfice métier de ces usages reste relatif et plutôt limité, bien qu’extrêmement mobilisateur de ressources. Et si nous prenions le temps d’analyser par exemple ce qu’apporte véritablement à nos métiers “l’IA générative” ? Car c’est bien au travers d’un usage enthousiaste de fonctionnalités ludiques et énoncées comme créatives que nous mettons collectivement en œuvre les nouveaux modèles sociaux (micro-travail, tâcheronage, travail invisible, sur-numérisation de la société, accès aux droits…) qui dessinent dès à présent l’avenir de nos métiers.

— En quoi l’IA aide-t-elle les communicant·es à contribuer aux transitions ?

En fin de compte, après cette analyse, je me demande encore en quoi le développement des modèles d’apprentissage automatique permet de contribuer à la lutte contre le réchauffement climatique ? De contribuer aux transitions écologiques ou sociales majeures que nous devons affronter ? J’avoue être bien humblement démuni, et ne pas avoir de réponse franche à proposer dès à présent. Cette incertitude, je vous la partage, comme humus d’une coopération que j’appelle de mes vœux, dans le but de construire ensemble des réponses à cette question.

␥ Pour aller + loin

- Aux origines de l'intelligence artificielle ↗ , France Culture, mars 2018

- Heather Knight, Premiers projets d'intelligence artificielle ↗ (sujet du projet étudiant : “Récupérer l’histoire du film sur l’intelligence artificielle du MIT”) , Laboratoire d’informatique et d’intelligence artificielle (CSAIL) / Massachusetts Institute of Technology (MIT), août 2006

- Cathy O’Neil, Les algorithmes exacerbent les inégalités ↗ , interview de Morgane Tual, Le Monde, novembre 2018

- coll. Priorités de recherche pour une intelligence artificielle robuste et bénéfique : Lettre ouverte ↗ (Research Priorities for Robust and Beneficial Artificial Intelligence: An Open Letter), décembre 2015

- Kate Crawford, Contre-atlas de l'intelligence artificielle ↗ , Zulma, mars 2022

- IA Act - Loi sur l'IA de l'UE ↗ : première réglementation de l’intelligence artificielle, Parlement Européen, décembre 2023

- AI Now Institute ↗

- Rapport '2023 Landscape' ↗ , AI Now Institute, Avril 2023

- Data Stream ↗ , intretien croisé entre Kate Crawford & Hito Steyerl, The New Inquiry, janvier 2017

- Vladan Joler & Kate Crawford, Anatomie d'un système d'IA ↗ : L’Amazon Echo comme carte anatomique du travail humain, des données et des ressources planétaires, 2018

- I Will Survive ↗ , Rétrospective Hito Steyerl au Centre Pompidou, avril 2021

- Les enjeux éthiques et sociaux de l’intelligence artificielle ↗ , débat avec Laurence Devillers, Antoinette Rouvroy et Dominique Cardon, BnF, février 2022

- Training Compute of Notable machine learning Systems Over Time ↗

- Articles de Creative Commons sur l'intelligence artificielle ↗

Article sous licence CC BY-SA 4.0

Cet article est diffusé sous licence Creative Commons BY-SA 4.0 Attribution - Partage dans les mêmes conditions

→ Vous êtes autorisé·e à :

Partager — copier, distribuer et communiquer cet article par tous moyens et sous tous formats

Adapter — remixer, transformer et créer à partir de cet article pour toute utilisation, y compris commerciale.

→ Selon les conditions suivantes :

Partage dans les mêmes conditions — Dans le cas où vous effectuez un remix, que vous transformez, ou créez à partir de cet article original, vous devez diffuser l'Œuvre modifiée dans les mêmes conditions, c'est-à-dire avec la même licence CC BY-SA 4.0

Attribution — Vous devez créditer le titre de l'article et son auteur, intégrer un lien vers cet article ainsi qu'un lien vers la licence CC BY-SA 4.0 et indiquer si des modifications ont été effectuées

Pour créditer cet article :

« IA : Envisager l'intelligence artificielle dans les pratiques de communication numérique, Guillaume Rouan, CC BY-SA 4.0 »

🔗 https://grouan.fr/2024/02/18/ia-envisager-intelligence-artificielle-dans-les-pratiques-de-communication-numerique/

🔗 https://creativecommons.org/licenses/by-sa/4.0/deed.fr

Permalien

https://grouan.fr/2024/02/18/ia-envisager-intelligence-artificielle-dans-les-pratiques-de-communication-numerique/